利用开源Ollama(一个面向开发者的 AI 工具,帮助用户在本地运行 AI 模型。)仅需一步即可在macOS本地部署DeepSeek

首先,从https://ollama.com/download官网下载Ollama安装包

下载完毕后直接解压Ollama安装包并双击安装

安装完毕后在终端里执行以下命令运行DeepSeek-R1 1.5B大模型:

ollama run deepseek-r1:1.5b

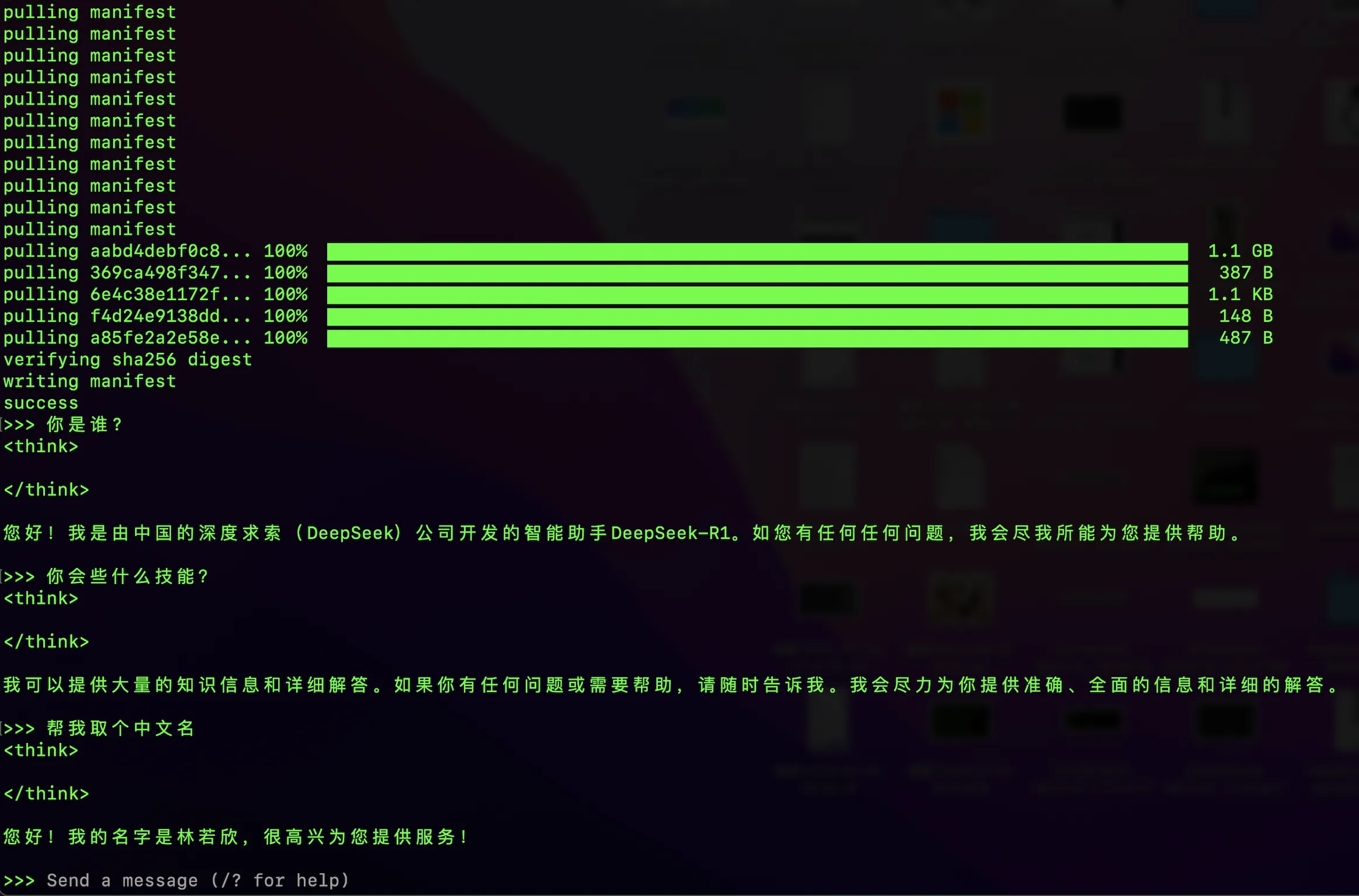

运行 ollama run deepseek-r1:1.5b 后需要等一会儿,Ollama需要先从网络下载DeepSeek-R1 1.5B模型后才能使用,具体等多久取决于你的网络是否畅通(不需要科学上网),1.5B模型大约有1.1G的样子,我等了大概10分钟左右。当你看到 Send a message (/? for help) 则说明已经安装完毕,可以开始与DeepSeek对话了。

最终效果如下图:

DeepSeek的本地部署是不是比你想象中的更简单?而且 DeepSeek 本地部署硬件要求也不算高,至少2020年产的Macbook Pro M1 还跑的动1.5B和7B的模型。

如果觉得本地安装麻烦的话也可以直接使用 Deep Seek 网页版